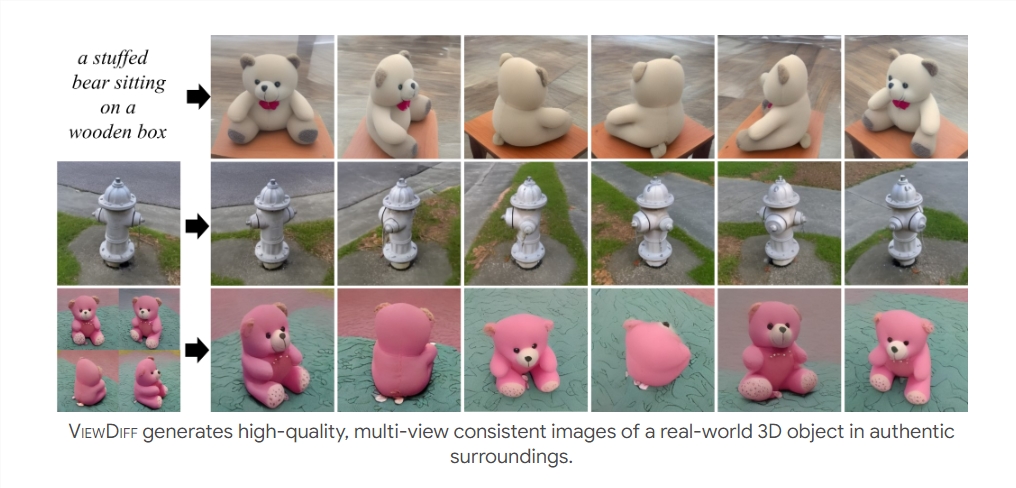

嘿,大家好!今天我要给大家介绍一个超酷的新模型——Meta推出的ViewDiff,这个模型可以帮助我们快速生成高质量多视角3D图像,听起来是不是很神奇呢?

你知道吗,传统的文本生成多视角3D图像一直存在着一些难题,比如无法生成真实背景环境、图像质量和多样性不理想,还缺乏多视角和一致性。但是现在有了ViewDiff,这些问题都可以迎刃而解了!这个模型引入了一种创新架构,利用文生成图模型和图像流生成器,再通过显式的3D建模,为图像赋予了一致性和多视角能力。

为了更好地捕获3D几何和全局风格,研究人员对原有的U-Net架构进行了创新,增强了跨帧注意力层和投影层。跨帧注意力层可以实现跨图像风格匹配,而投影层则将多视图2D特征集成为显式的3D体素特征,确保了输出图像的3D几何一致性。此外,ViewDiff还开发了自回归生成模块,可以在任意视角上生成更多的3D一致性图像,进一步提升了模型的生成能力。

这个研究填补了文本生成多视角3D图像领域的技术空白,为游戏开发、元宇宙等行业提供了更便捷、高效的模型构建方案。不仅在技术层面上具有重大意义,而且将为未来的3D图像生成领域带来更多创新可能。想要了解更多关于这个模型的信息,可以点击论文地址或项目地址查看哦!